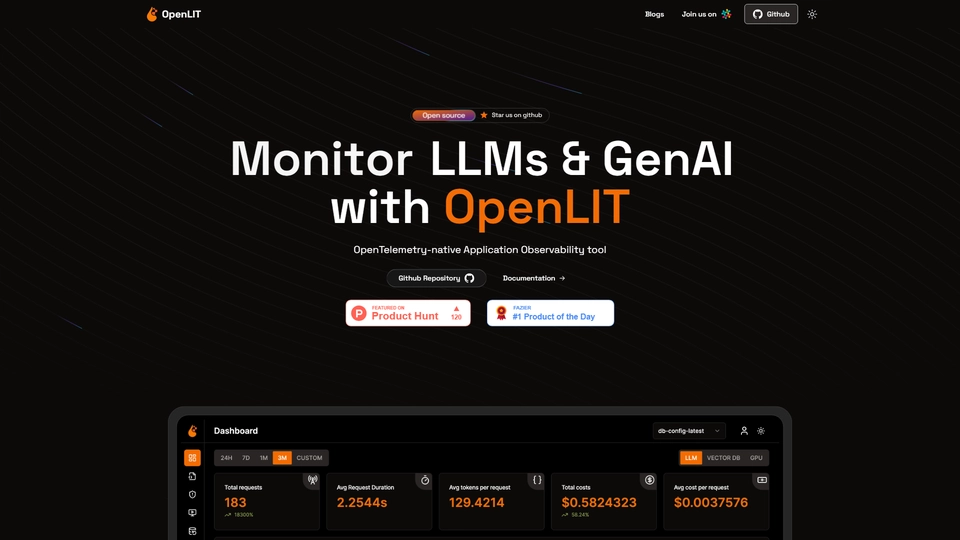

Qu'est-ce que Openlit

Openlit se présente comme un outil incontournable pour les développeurs travaillant avec des modèles de langage (LLM) et l'infrastructure GPU. Développé par Aman et son équipe, Openlit s’impose comme le premier système d'observabilité et d'analyse réellement open-source basé sur OpenTelemetry. Sa mission principale est de simplifier la surveillance de toute la pile LLM, depuis les applications elles-mêmes jusqu'à la couche d'infrastructure GPU, en ne nécessitant qu'une seule ligne de code pour l'intégration.

Openlit aborde des défis communs que rencontrent de nombreux ingénieurs LLM, tels que des sorties probabilistiques imprécises, des coûts d'inférence élevés et une latence importante due aux temps de réponse allongés des LLM. L'outil vise à transformer ces obstacles en opportunités en fournissant des données cruciales et des observations sur les performances des applications LLM.

En tant que plateforme open-source, Openlit offre plus de vingt intégrations, notamment avec OpenAI et LangChain, et permet l'exportation des données vers vos outils d'observabilité existants. Cela en fait une solution flexible et hautement intégrable pour les développeurs et les industries nécessitant une surveillance et une optimisation poussées des applications LLM et de leur comportement utilisateur. Grâce à cela, les entreprises peuvent non seulement maintenir mais également améliorer la sécurité et l'efficacité de leurs applications d'IA.

Openlit Fonctionnalités

OpenLIT est un outil open-source d'observabilité et d'analyse pour les applications LLM et l'infrastructure GPU. Voici un ensemble de fonctionnalités clés qui le distinguent.

Fonctionnalités de base

OpenLIT offre une journalisation complète, enregistrant les requêtes, erreurs et métriques pour chaque demande. Cela permet aux développeurs de suivre et de comprendre le comportement des applications LLM.

Options de personnalisation

En tant que plateforme open-source, OpenLIT est hautement personnalisable et s'intègre à plus de 20 outils d'IA, tels qu'OpenAI et LangChain, offrant une flexibilité unique pour adapter l'outil aux besoins spécifiques.

Capacités d'automatisation

Avec des fonctionnalités telles que le calcul automatique des coûts pour les modèles personnalisés et fine-tunés, OpenLIT aide à optimiser les budgets tout en simplifiant la gestion des ressources.

Avantages pour les utilisateurs

OpenLIT facilite le suivi des interactions utilisateurs et la collecte efficace de feedback, aidant les développeurs à comprendre et à améliorer l’expérience utilisateur.

Points de vente uniques

Un Playground de prompts intégré permet de tester et d'optimiser différentes invites et modèles LLM, offrant un espace interactif pour ajuster et améliorer les performances.

Ces fonctionnalités contribuent à faire d'OpenLIT une solution robuste pour les développeurs cherchant à optimiser l'observabilité et la performance de leurs applications LLM.

Openlit FAQ

Openlit Questions Fréquemment Posées

Qu'est-ce qu'OpenLIT exactement?

OpenLIT est une plateforme open-source d'observabilité et d'analytique, basée sur OpenTelemetry, conçue pour surveiller l'ensemble de la stack LLM, depuis les applications jusqu'à l'infrastructure GPU.

Quels sont les principaux avantages d'utiliser OpenLIT?

OpenLIT offre un logging complet, une interface visuelle pour le suivi des coûts et de la latence, le suivi des utilisateurs, un espace de test des prompts, et une intégration fluide avec vos outils d'observabilité existants.

Comment OpenLIT facilite-t-il l'intégration avec d'autres outils IA?

OpenLIT prend en charge plus de 20 intégrations, y compris OpenAI et LangChain, permettant d'exporter des données vers votre stack d'observabilité existante sans difficulté.

Découvrez les Alternatives à Openlit

LLMWare IA optimise la sécurité et l'efficacité en entreprise avec des modèles légers et déployables localement.

15/10/2024

DevKit IA 3.0 optimise le développement avec des modèles puissants et une intégration fluide VSCode.

15/10/2024

GitHub Models IA révolutionne le développement en améliorant l'efficacité grâce à l'automatisation intelligente du code.

11/10/2024

Langtail IA simplifie le développement d'applications IA, garantissant des déploiements rapides sans surprises.

20/10/2024

Helicone AI simplifie l'observabilité et améliore les applications IA avec une intégration rapide.

09/10/2024

Unify IA optimise le routage des prompts vers les modèles LLM idéaux pour meilleur équilibre performance.

08/10/2024