¿Qué es Ferret IA Multimodal

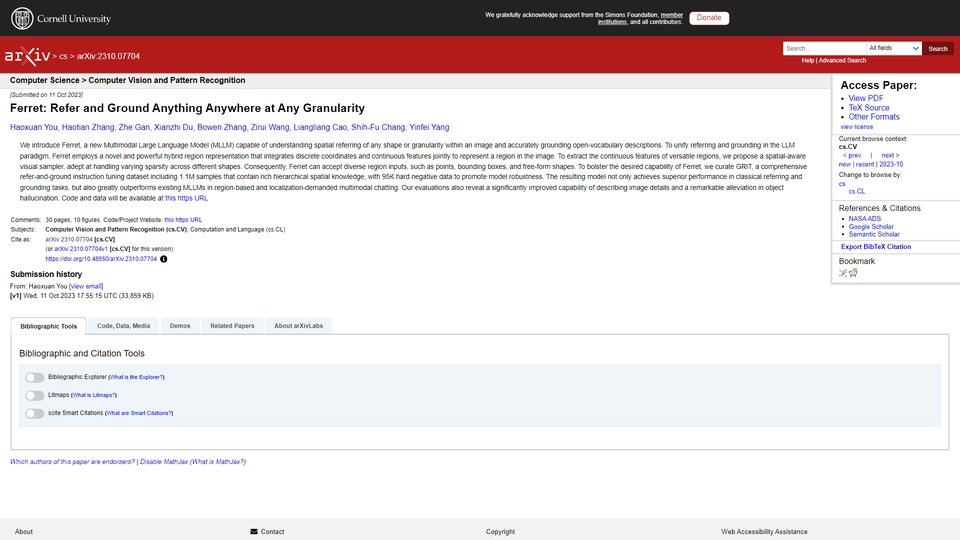

Ferret es un innovador modelo de lenguaje multimodal (MLLM) desarrollado por Apple, diseñado para transformar la comprensión de imágenes y el procesamiento del lenguaje. Este producto de inteligencia artificial destaca por su capacidad para manejar referencias espaciales, un aspecto crucial en aplicaciones que requieren una interpretación precisa de la relación entre objetos y su entorno en imágenes.

En un mundo digital donde la interacción entre imágenes y texto es cada vez más relevante, Ferret aborda el reto de integrar estas dos modalidades para ofrecer soluciones más completas y precisas. Las tecnologías convencionales a menudo enfrentan dificultades al manejar ambos aspectos de manera eficaz, pero Ferret aporta una ventaja significativa al hacerlo con fluidez y precisión.

El público objetivo de este avance tecnológico incluye desarrolladores e industrias que operan en el ámbito de la visión por computadora, procesamiento del lenguaje natural, y aplicaciones de inteligencia artificial complejas, como el sector de la robótica y la automoción. Las empresas que buscan mejorar las interacciones de usuario a través de interfaces más intuitivas se beneficiarán enormemente de las capacidades de Ferret.

Gracias a su enfoque innovador, Ferret se posiciona como un producto clave en el campo de la inteligencia artificial multimodal, ofreciendo nuevas oportunidades para la evolución de tecnologías que dependen de la sinergia entre lenguaje e imágenes.

Ferret IA Multimodal Características

Ferret es un nuevo tipo de modelo de lenguaje grande multimodal (MLLM) desarrollado por Apple. A continuación, se presentan algunas de sus características clave:

Funcionalidades principales

Ferret destaca en dos áreas cruciales de procesamiento de información:

- Entendimiento de Imágenes: Tiene una capacidad avanzada para analizar y comprender imágenes, lo que le permite identificar y procesar detalles visuales con precisión.

- Procesamiento del Lenguaje: Su habilidad para entender y generar lenguaje humano mejora la interacción y la capacidad de respuesta, especialmente en contextos complejos.

Ventajas clave sobre los competidores

Ferret ofrece ventajas significativas sobre otros modelos similares:

- Comprensión Espacial Avanzada: El modelo sobresale en interpretar referencias espaciales, una característica que lo diferencia de otros MLLM en el mercado.

- Integración Multimodal: Combina de manera efectiva la comprensión de imágenes y lenguaje, proporcionando una experiencia de usuario más integrada y rica.

Beneficios para los usuarios

Los usuarios de Ferret pueden disfrutar de beneficios específicos:

- Interacciones Mejoradas: La capacidad combinada de procesar imágenes y lenguaje puede mejorar aplicaciones en áreas como la robótica, realidad aumentada, y más.

- Soluciones Personalizadas: Gracias a su excelente comprensión del contexto, Ferret puede adaptarse a soluciones personalizadas en diversos campos tecnológicos.

Para ilustrar sus capacidades, podría ser útil emplear gráficos que muestren cómo Ferret procesa y combina datos visuales y textuales para ofrecer una experiencia más robusta y dinámica.

Ferret IA Multimodal Preguntas Frecuentes

Ferret IA Multimodal Preguntas Frecuentes

¿Qué es un modelo de lenguaje multimodal (MLLM)?

Un modelo de lenguaje multimodal (MLLM) es una tecnología de inteligencia artificial que puede procesar y entender diferentes tipos de datos, como texto e imágenes, simultáneamente. Este tipo de modelos está diseñado para combinar habilidades de procesamiento de lenguaje natural y visión por computador, permitiendo interacciones más ricas y contextualmente relevantes.

¿Cuáles son las ventajas del nuevo MLLM de Apple en el entendimiento de referencias espaciales?

El nuevo modelo de lenguaje multimodal (MLLM) de Apple sobresale en la comprensión de referencias espaciales, lo que significa que puede interpretar y entender mejor la disposición y relación espacial de los objetos en una imagen, así como describir y contextualizar estas relaciones en lenguaje natural.

¿Cómo puede el MLLM de Apple mejorar las aplicaciones actuales?

El MLLM de Apple puede mejorar aplicaciones en campos como la realidad aumentada, la robótica y la asistencia virtual, proporcionando interacciones más naturales y precisas gracias a su habilidad para entender y procesar tanto imágenes como lenguaje, especialmente en situaciones donde las relaciones espaciales son cruciales.