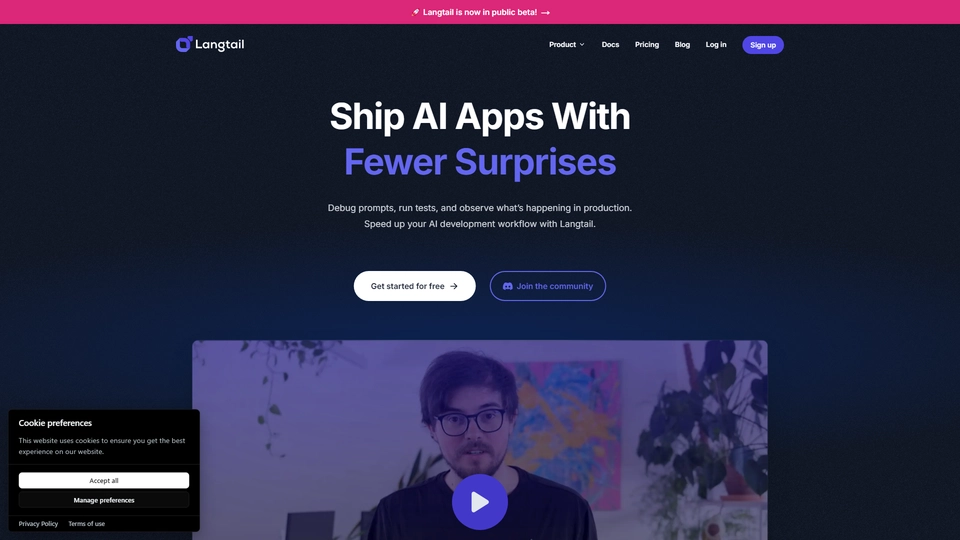

Co to jest Langtail Public Beta

Langtail Public Beta pojawia się jako innowacyjne rozwiązanie dla zespołów deweloperskich, które poszukują skuteczniejszych sposobów na tworzenie i wdrażanie aplikacji napędzanych przez sztuczną inteligencję. Stworzony z myślą o ułatwieniu procesu rozwijania aplikacji AI, Langtail oferuje kompleksową platformę LLMOps, która pozwala przyspieszyć rozwój i wyeliminować niespodzianki przy wdrażaniu aplikacji do produkcji.

Za Langtail stoi Petr, współzałożyciel i CEO, który dzięki rozmowom z wieloma twórcami i inżynierami, zidentyfikował kluczowe wyzwania stojące przed zespołami budującymi aplikacje AI. Problemem okazała się nieprzewidywalność modeli językowych, trudności w tworzeniu efektywnych promptów, oraz zmieniające się best practices związane z używaniem dużych modeli językowych (LLM).

Langtail oferuje narzędzia, które adresują te problemy – od możliwości debugowania promptów, poprzez testowanie i śledzenie aktywności w środowisku produkcyjnym, aż po zwiększoną widoczność w działaniu aplikacji. Dzięki temu, zespoły mogą skupić się na uszlachetnianiu swojego produktu zamiast borykać się z technicznymi przeszkodami.

Swoje rozwiązanie Langtail kieruje do branż technologicznych i zespołów inżynierskich, które chcą efektywnie przekształcać swoje pomysły w gotowe produkty z wykorzystaniem zaawansowanej technologii AI. Jako nowoczesne narzędzie, Langtail oferuje nie tylko korzyści związane z wydajnością, ale także nowe możliwości w kontekście tworzenia innowacyjnych rozwiązań na rynku AI.

Langtail Public Beta Funkcje

Langtail to platforma LLMOps, która wspomaga zespoły w szybszym rozwijaniu aplikacji opartych na sztucznej inteligencji i ich wdrażaniu. Poniżej znajduje się szczegółowy opis najważniejszych funkcji produktu Langtail Public Beta.

Podstawowe funkcjonalności

Langtail oferuje zestaw narzędzi, które umożliwiają zespołom efektywne debugowanie i współpracę nad zestawieniami promptów. Platforma pozwala na tworzenie i testowanie promptów LLM, co umożliwia zespołom sprawną nawigację po nieprzewidywalnościach modeli AI. Zintegrowany system testowy umożliwia analizę, jak wprowadzone zmiany wpływają na wyniki promptów, co jest kluczowe dla doskonalenia i utrzymania jakości aplikacji AI.

Observability i metryki wydajności

Langtail zapewnia zaawansowane funkcje monitorowania, które dostarczają wglądu w działanie promptów w rzeczywistych warunkach. Logi i metryki pomagają użytkownikom monitorować kluczowe wskaźniki takie jak latencja i koszty. To narzędzie jest niezwykle istotne dla zapewnienia, że aplikacja działa zgodnie z oczekiwaniami i że mogą być szybko zauważone i rozwiązane wszelkie problemy związane z wydajnością.

Możliwości automatyzacji i wdrożeń

Platforma umożliwia publikację zakończonych promptów jako API endpoints, co upraszcza ich integrację z aplikacjami. Dzięki tej funkcji zespoły mogą szybko uruchamiać i wykorzystywać prompty w rzeczywistych środowiskach produkcyjnych, co znacząco przyspiesza cały proces wdrożenia aplikacji AI.

Korzyści dla użytkowników

Langtail ułatwia zespołom przenoszenie aplikacji AI z etapu proof-of-concept do gotowego produktu, który można dostarczyć użytkownikom końcowym. Umożliwiając zespołom szybkie debuggowanie, obserwację i optymalizację promptów, Langtail pomaga minimalizować niespodzianki w produkcji i skraca czas potrzebny na wejście na rynek.

Dzięki powyższym funkcjom Langtail wyróżnia się jako narzędzie, które skutecznie rozwiązuje problemy związane z nieprzewidywalnością LLM i ułatwia cały proces tworzenia i wdrażania aplikacji AI.

Langtail Public Beta Często Zadawane Pytania

Langtail Public Beta Najczęściej Zadawane Pytania

Czym jest Langtail?

Langtail to platforma LLMOps pomagająca zespołom w przyspieszeniu rozwoju aplikacji opartych na AI oraz ich wdrażaniu z minimalną ilością nieprzewidzianych problemów. Umożliwia debugowanie promptów, przeprowadzanie testów i obserwację pracy w produkcji.

Jakie są główne funkcje Langtail?

Langtail oferuje kilka kluczowych funkcji: Playground do debugowania i współpracy nad promptami, narzędzia testowe do oceny wpływu zmian w promptach, możliwość wdrażania promptów jako punktów końcowych API oraz narzędzia do obserwacji logów i monitorowania wydajności.

Jakie korzyści oferuje Langtail dla zespołów deweloperskich?

Langtail ułatwia zespołom transformację dowodów koncepcji w gotowe produkty dzięki narzędziom do debugowania, testowania, wdrażania i monitorowania. Rozwiązuje wyzwania związane z nieprzewidywalnością modeli LLM, tworzeniem efektywnych promptów i adaptacją do najlepszych praktyk.

Odkryj Alternatywy dla Langtail Public Beta

AI DevKit 3.0 usprawnia proces tworzenia oprogramowania, łącząc wiele modeli LLM i narzędzi w jednym miejscu.

15.10.2024

OpenLIT AI Monitor oferuje zaawansowane analizy i śledzenie dla aplikacji LLM, wzmacniając ich wydajność i efektywność.

22.10.2024

GitHub AI Models to innowacyjne narzędzie wspomagające programistów w automatyzacji kodowania i zwiększaniu efektywności pracy.

11.10.2024

LLMWare AI Solutions umożliwia bezpieczne wdrażanie lokalnych modeli językowych, zwiększając produktywność w sektorach regulowanych.

15.10.2024

Helicone AI to innowacyjna platforma do łatwego monitorowania i optymalizacji aplikacji AI opartych na modelach językowych.

9.10.2024

Hey AI CLI to darmowe narzędzie wspierające programistów w rozwiązywaniu błędów dzięki zaawansowanej technologii AI.

9.10.2024

Unify AI Platform rewolucjonizuje zarządzanie aplikacjami LLM, automatycznie optymalizując wybór modelu i dostawców.

8.10.2024